AI - Facts and myths (Q&A)

Q&A to an Invited Lecture at the WSB Merito University.

Krzysztof Michalik

10/8/202413 min czytać

Q&A - Answers to some questions asked after the lecture will appear next week here on the blog

PL

(Odpowiedzi na pytania z wykładu na które nie zdążyłem odpowiedzieć lub z ograniczeń czasu wymagały rozszerzenia z mojej strony)

Jeszcze raz dziękuję Państwu za udział w moim wykładzie na temat faktów i mitów związanych z AI. Odpowiadam na niektóre pytania i przy okazji dołączam fragmenty video, które część z Państwa bardzo zainteresowały, w tym także linki do interesującej debaty prof. Richard Dawkins vs prof. Denis Noble. Dodałem linki do wypowiedzi teorii "świadomości kwantowej" wg Stuarta Hameroffa i prof. Rogera Penrose, jako przykładu 1 z nowszych teorii świadomości.

Wybrałem kilka stwierdzeń, pytań z czatu podczas i po wykładzie, zachowując oczywiście anonimowość autorów - będę oznaczał te wypowiedzi skrótami U1 - Un (U - Uczestnik). Z powodów technicznych nie odpowiadam oraz nie rozszerzam (pogłębiam) treści i wyjaśnień zgodnie z rzeczywistą chronologią na czacie..

U1:

Wydaje się, że duże zainteresowanie wzbudził problem świadomości w AI, w tym także mikrotubule i ich związek z determinizmem DNA oraz pomysłem wyjaśnienia świadomości obecnością tzw. mikrotubuli w neuronach mózgu (de facto one są obecne także w pozostałych rodzajach komórek ludzkiego ciała.

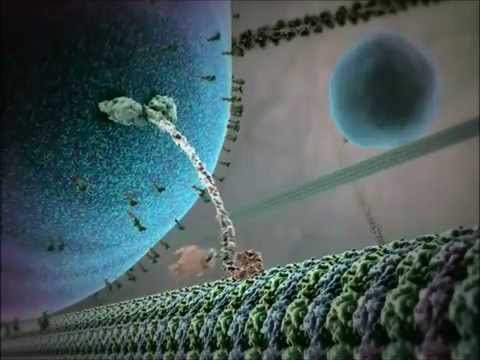

Video 1: Białko kinesyny chodzące po mikrotubuli

Credit: Emmanuel Dumont (YT channel)

Komórki nerwowe podobnie jak pozostałe komórki mają na ogół te same organelle komórkowe, choć różnią się morfologią, np. wypustkami nazywanymi dendrytami i aksonami. W tym kontekście - tj. świadomości człowieka i sztucznej inteligencji (?) - ważne są mikrotubule, które także w nich występują. Video 2 pokazuje animację w neuronie:

Video 2: Transport wewnątrz mózgu: podstawowe mechanizmy transportu neuronalnego

Credit: Hoogenraad Lab (YT channel)

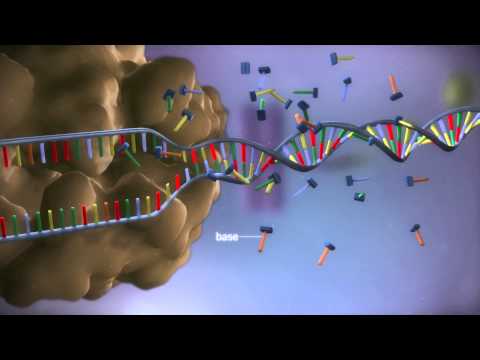

By zrozumieć całą złożoność "maszynerii" komórki i miejsce w tym wszystkim DNA/RNA oraz mikrotubul, zwłaszcza w kontekście debaty prof. Dawkinsa i prof. Noble'a, w tym stwierdzeń o DNA jako księgi życia vs "wolnej woli" i zewnętrznym wpływie na DNA, warto zapoznać się z budową komórki i rolą poszczególnych organelli (czyli składowych komórki). Myślę, że należy także, choćby w zarysie przypomnieć sobie jak tworzone jest białko na podstawie zapisu w DNA (czyli DNA -> RNA -> białka, a w tym procesie poza translacją DNA->RNA biorą udział rybosomy tj. "fabryki białek" składających z godnie z zapisem genów w DNA (potem już mRNA) odpowiednie aminokwasy w odpowiedniej kolejności. W zrozumieniu tych procesów i tej skomplikowanej maszynerii wewnątrz każdej z naszych komórek, w tym nerwowych pomocne mogą być znakomite animacje podane niżej w formie video:

Video 3: From DNA to protein - 3D

Credit: yourgenome (YT channel)

Video 4: DNA animation 3D

Credit: WEHImovies (YT channel)

Video 5: Denis Noble explains his revolutionary theory of genetics | Genes are not the blueprint for life

Credit: The Institute of Art and Ideas (channel on YT)

Video 6: The unselfish gene | Denis Noble challenges Richard Dawkins (debata/polemika obu naukowców )

Credit: The Institute of Art and Ideas (channel on YT)

Po poznaniu choćby w zarysie rzeczywistej funkcji DNA i mikrotubul, można zrozumieć także krytycyzm wobec nowej teorii świadomości kwantowej zaproponowanej przez Stuarta Hameroffa i prof. Rogera Penrose'a. W tej teorii mikrotubule odgrywają podstawową rolę. Niżej przykłady wypowiedzi obu panów na temat świadomości, w przypadku Rogera Penrose'a jest to uzasadnione także faktem, że dość często wspomina nie tylko o świadomości ale także o sztucznej inteligencji:

Video 7: Dr. Stuart Hameroff, M.D. — Microtubules & quantum consciousness

Credit: 2045 Initiative (channel on YT)

Video 8: What are Microtubules? - Joe Rogan and Sir Roger Penrose

Credit: McRelevant (channel on YT. Pełna wersja wywiadu z prof. Penrose tu: https://www.youtube.com/watch?v=GEw0ePZUMHA&t=16s)

U2: Pytania o możliwe zastosowania w życiu codziennym, np. w pracy

Choć od pewnego czasu w różnych wypowiedziach, w tym esejach na temat AI, często wypowiadam się krytycznie, to jedynie w związku z dużym szumem informacyjnym, dezinformacją (świadomą lub nie) i przestrzegam przed nadmiernym huraoptymizmem w wypowiedziach niektórych osób w mediach. Nie zmieniła się jednak moja ocena korzyści wynikających z zastosowań AI (tych już praktycznie zrealizowanych i tych potencjalnych). Nadal uważam tę dziedzinę jako bardzo perspektywiczną i mogącą się rozwijać w długim, dającym się przewidzieć horyzoncie czasu (nb. stąd moja konkluzja, że warto studiować i zajmować się sztuczną inteligencją, ale racjonalnie i profesjonalnie tj. w oparciu o rzetelną wiedzę fachową).

Pomijając zatem nonsensy w rodzaju osiągnięcia przez AI świadomości lub np. osiągnięciu przez nią inteligencji 8-letniego dziecka itp. wypowiadanymi przez "ekspertów" (czyli owe mity), istnieje już wiele faktów i to od przynajmniej 3-4 dekad pokazujących, że AI jest i może być bardzo pomocna w rozwiązywaniu wielu problemów praktycznych, w tym codziennych również w pracy zawodowej.

Myślę, że przełom nastąpił już za sprawą systemów ekspertowych w latach 70., które pokazały skuteczność rozwiązywania realnych problemów w medycynie (np. systemy MYCIN, Internist), geologii (system Prospector) czy nawet w konfigurowaniu systemów komputerowych w firmie DEC (system R1/XCON). Do dziś wykorzystywany jest (juz pod zmienioną nazwą) jeden z pierwszych systemów ekspertowych (rozwijany od około 1968 roku) o nazwie MACSYMA i przeznaczony do wspomagania obliczeń algebraicznych np. w zakresie upraszczania czy rozwiązywanie układów równań. Był na tyle skuteczny, że wspomagał pracę wielu specjalistów w praktycznych obliczeniach i to dzięki pierwotnej wersji współczesnego Internetu czyli sieci ARPANET (od 1969 roku). Do dziś działa pochodna tego systemu o nazwie MAXIMA (tu strona: https://maxima.sourceforge.io/ ).W latach 80. ta klasa systemów AI okazała się skuteczna w niektórych zastosowaniach ogólnie ujmując ekonomicznych/biznesowych. Dotyczyło to np. systemów ekspertowych w bankach do wspomagania decyzji kredytowych (np. system Lending Advisor), w ubezpieczeniach (system Underwriting Advisor), czy finansowo podatkowych (np. Taxman, TaxAdvisor i inne). Sam miałem w tym udział i stąd powstały aplikacje dziedzinowe moich narzędzi np. w diagnostyce produkcji układów scalonych - system Diagnosta MC14007 opracowany we współpracy z dr. inż. Tomaszem Guttem z ITE i CEMI w Warszawie, system Salomon do diagnostyki depresji (z dr. n. med. Krzysztofem Kielanem) czy w ramach mojej firmy aplikacja Aitech DSS do wspomagania decyzji kredytowych i finansowych.

W pewnym momencie do gry wróciły sztuczne sieci neuronowe po pogłębieniu uczenia i rozwiązaniu problemu nieliniowości. W rezultacie ta klasa systemów AI także dołączyła do praktycznych zastosowań m.in. w prognozowaniu, analizie i interpretacji danych czy w zastosowaniach o charakterze klasyfikacyjnych. Po drodze pojawiły się systemy z głębokim uczeniem, systemy klasy CBR czy względnie nie dawno systemy wykorzystujące wielkie modele językowe (LLM). Wraz z tym znowu zwiększył się zakres realnych i wciąż także potencjalnych zastosowań. Np. systemy neuronowe splotowe (CNN) znakomicie sprawdziły się w bardziej złożonych zagadnieniach np. przetwarzania obrazów. Obecnie np. w programowaniu systemy AI niewątpliwie mogą odgrywać istotną rolę wspomagania (!) pracy programisty, ale jak mówiłem na wykładzie nigdy go nie zastąpią - to jest ten aspekt krytycyzmu, związanych z przesadnymi i nieuzasadnionymi merytorycznie oczekiwaniami od AI. Myślę, że raczej klasa problemu a nie konkretna dziedzina są wskazaniem do zastosowań. To było widać już na przykładzie systemów ekspertowych, które sprawdziły się w zastosowaniach diagnostycznych, klasyfikacyjnych, związanych z interpretacją danych i nie było (jest) istotne czy chodzi o medycynę, geologię czy technikę, ważna była i jest klasa problemu. I w drugą stronę dobór narzędzi/klas systemów - np. chatboty oparte na LLM są dużym osiągnięciem na gruncie AI i mogą być bardzo użyteczne, ale z pewnoście nie w dziedzinach gdzie nie można pozwolić sobie na rozwiązania z "halucynacjami". Np. do celów skutecznego prognozowania wielu zjawisk, niekoniecznie ekonomicznych, nadal w zupełności wystarczą klasyczne sieci neuronowe (MLP i pochodne) i nie potrzeba do tego chatbotów opartych na LLM. Większość wspomnianych yu klas systemów AI nie ma przypadłości "halucynowania". Czyli to zawsze decyzja człowieka by dobrać odpowiednie narzędzie AI do odpowiedniej klasy problemów czy konkretnego zadania - można kroić chleb skalpelem i być może operować z użyciem noża, ale nie jest to dobre rozwiązanie. :)

U3: Czy (AI) może rozwinąć się do uzyskania lub symulowania chociaż świadomości, skoro jej nie posiada. Czy dojdzie do momentu gdy nie będziemy w stanie jej zrozumieć/ zapanować nad nią? Tzn. wygeneruje własną tezę lub odkryje coś na własną rękę.

Według mnie świadomość nie jest efektem jakiegoś deterministycznego algorytmu, zatem świadomość tak jak ją rozumiemy, czy może odczuwamy jej istnienie w nas nigdy nie będzie osiągnięta przez AI. Jak mówiłem na wykładzie dalecy jesteśmy nawet od zrozumienia istoty samego zjawiska, choć każdy z nas ma jakieś poczucie istnienia jej. Dlatego nawet nie próbuję zdefiniować świadomości w jednym czy w kilku typowych dla prostych definicji, zostawiając to pojęcie niczym pojęcie pierwotne w matematyce. Nawet zdefiniowanie łatwiejszej cechy jaką jest inteligencja nie jest proste bo każdy rozumie ją trochę inaczej, ma inną opinię na temat tego czym jest- wg mnie na pewno nie jest nią coć co mierzy IQ, IQ coś mierzy tylko czy to jest inteligencja? Według mnie nie, bo czy jedna liczba może opisywać tak wielokryterialną cechę jak inteligencja? Czy inteligencja Mozarta była mniejsza od np. Einsteina, a może jego talent muzyczny to inny sposób manifestacji tej cechy? Te testy nie uwzględniają kreatywności i innych przejawów aktywności intelektualnej człowieka, a to jedna z najważniejszych cech w ocenie efektów działalności.

Osiągnięcie tego typu punktu przez AI bywa określane właśnie jako osobliwość (ang. singularity) i jeśli dodamy do tego słowo symulacja to w pewnych zakresach AI będzie w stanie (już bywa) imitować inteligencję człowieka, na ogół jednak w zawężonych dziedzinach. Do pewnego stopnia będzie można uzyskać symulację i w efekcie iluzję świadomości - jak wspominałem na wykładzie niektóre osoby z różnych powodów "odkryły" czy dopatrzyły się świadomości, dotyczy to zwłaszcza niektórych chatbotów. To rodzi pytanie w jakim stopniu wynika to z ignorancji, albo z nieświadomości pewnych faktów lub np. kwestii marketingowych i kwestii biznesowych jak np. granty i różne formy dofinansowania itp.

Sprawa naszego rozumienia lub nierozumienia wymaga doprecyzowania. Mam na myśli fakt, że np. z powodu złożoności i/lub komplikacji danego problemu wynik nie jest dla nas oczywisty. To oczywiście nie oznacza, że np. programista, projektant danego systemu nie rozumie jak on działa, bo to jest zupełnie inny problem. To należy podkreślić, bowiem niedawno przeczytałem wypowiedź jednego z fizyków, który napisał, że "[..] Człowiek nauczył się tworzyć sztuczną inteligencję, ale nie jest w stanie zrozumieć, jak ona działa – stwierdził [..]". Informatycy, w tym specjaliści w dziedzinie AI tak nie działają. Tak się nie da tworzyć systemów, w tym AI; być może niespecjaliści nie rozumieją zasad działania AI (o ile jest sens mówić ogólnie o AI, bo wg mnie trzeba mówić o konkretnej klasie systemów czy nawet konkretnym systemie). Specjaliści rozumieją zasadę działania tworzonych przez siebie systemów, jedynie wynik konkretnego działania może być trudny do ustalenia z powodu, o którym wspomniałem ale to dotyczy zwykłego kalkulatora z prostymi operacjami czy funkcjami. Poza sawantami być może, kto w głowie ustali wynik silni dla wartości 123 czy wartość funkcji sinus dla argumentów 0 czy 90 stopni - o lub 1, ale dla wartości pomiędzy nimi już nie tak szybko, chyba, że ktoś nauczy się na pamięć tablic wartości tej funkcji i to z określonym krokiem oraz dokładnością. To jak zadanie określenia dnia tygodnia (czy np. poniedziałek lub wtorek) 14 lutego 20467 roku - czytałem, że byli sawanci, którzy sprawnie takie operacje w mózgu przeprowadzali ale poza tym mieli poważne deficyty intelektualne. Mówienie więc, że nie rozumiemy jak działają współczesne systemy AI jest nieprawdą, inaczej by nie powstały - to jest informatyka. To i wiele innych wypowiedzi na temat AI przez osoby spoza tej dziedziny wynika w ogóle ze stanu świadomości, w którym one na ogół znają głównie chatboty i nie mają świadomości wielu innych klas systemów AI oraz ich ewolucji, czasami wzajemnych powiązań czy związków. To właśnie fakt, że moda na AI przyciągnęła wiele osób spoza tej dziedziny i zachęciła do publicznych, czasami w mediach o dużym zasięgu, wypowiedzi na jej temat z bardzo mocnymi tezami (przypomnę tu słowa prof. Carla Sagana z wykładu) jest powodem pewnego zamieszania i wielu iluzji w percepcji AI. Informatyka , w tym AI nie jest magią tylko racjonalnym, inżynierskim bez mała sposobem tworzenia, gdzie nadal obowiązują projektanckie i programistyczne zasady testowania, walidacji i weryfikacji systemów.

Co do procesu wygenerowania własnej tezy lub własnego odkrycia, to wymagałoby (o ile dobrze zrozumiałem intencję pytania) posiadania własnej woli, by samodzielnie system stawiałby sobie takie pytania czy zadania, jeśli to nie byłoby zamierzeniem twórców. Aż tak wielka samodzielność wymagałaby wg mnie właśnie świadomości dającej wolną wolę (o wolnej woli zamiast "programu" w DNA mówił prof. Denis Noble, choć w skali mikro tj. komórki i genomu w jądrze. Natomiast jeśli generowanie hipotez, tez byłoby jednym z zamierzonych celów twórców i niejako wkomponowanych (zaprogramowanych, wyuczonych) celów systemu to w pewnym zakresie tak. Już ok. 1974 roku system ekspertowy Prospector odkrył duże złoża molibdenu o wartości ok. 100 mln. dolarów na podstawie dostarczonych mu danych geologicznych, ale to było m.in. celem tego systemu. Miał odpowiednią bazę wiedzy opracowaną przez informatyków we współpracy z geologami - takich przykładów można podać bardzo wiele. Tylko tu znowu trzeba byłoby ustalić co rozumiemy w kontekście tego pytania przez odkrycie podobnie o jaki rodzaj tez chodzi. Np. systemy dedukcyjne wyprowadzają nowe fakty wcześniej nieobecne jawnie wśród przesłanek systemu, czyli w pewnym wąsko-rozumianym sensie nową wiedzę, ale w ramach istniejącego zbioru/bazy wiedzy danego systemu dedukcyjnego.

U4:

Czy widzi Pan jakieś obszary w których należałoby ograniczyć lub zacząć wykluczać zastosowanie AI by współczesny człowiek nie zaczął się uwsteczniać, czy stawał się ograniczony?

(Odpowiedzi dodane 10 X 2024)

Niestety na wiele procesów nie mamy wpływu, na szczęście na wiele mamy i najogólniej odpowiadając myślę, że tam gdzie należy ingerować oraz mamy na to wpływ to powinniśmy regulować dostęp lub sposób użycia AI. Tu przez AI rozumiem nie całą subdyscyplinę wiedzy z dziedziny informatyki lecz konkretne systemy i zastosowania. Na powszechność AI nie mamy wpływu i nie to samo w sobie jest problemem. Obawiam się, że przypuszczenie w pytaniu jest trafne i nie każdy ale prawdopodobnie AI wzmocni w części społeczeństwa pewne negatywne w mojej opinii procesy, zwyczaje tak jak dokonały tego telewizja o później Internet (przy wszystkich ogromnych zaletach tych wynalazków). Spadło czytelnictwo, cywilizacja stała się bardziej "obrazkową" w sensie percepcji form przekazu, do tego czas przekazu - nawet filmy video stają się krótsze (tzw. shorty czy kariera Tik Toka itp.). Telewizja (poza innymi kwestiami) i dostępność kanałów z filmami osłabiła czytelnictwo, Internet mógł osłabić u niektórych osób wolę uczenia się, zapamiętywania części wiedzy (po co jest Wikipedia, są portale internetowe dostępne w każdej chwili). Czyli trochę "dar" ale i "przekleństwo". AI wzmocni te aspekty Internetu i doda do tego poza zwolnieniem części z nas z chęci uczenia się różnych rzeczy i zapamiętywania o rozwiązywanie problemów. Choć w Internecie w małym procencie już istniały wyspecjalizowane portale rozwiązujące wybrane problemy (np. Wolfram Alpha (tu adres: https://www.wolframalpha.com/ )), to dopiero współczesne systemy AI, w tym np. czatboty, mogą być tym istotnym elementem "rozleniwiającym" społeczeństwo w kolejnym aspekcie, czyli rozwiązywania problemów. I znowu, jest to ogromny walor, ale też zagrożenie, jeśli będziemy nieświadomi niektórych ograniczeń i zjawisk, jakie niesie obecny stan rozwoju niektórych klas systemów AI (np. wspomniane przeze mnie halucynacje). Czyli do bezpiecznego i efektywnego korzystania z AI trzeba być przygotowanym i świadomym niektórych pułapek.

Drugi aspekt związany z pytaniem, a dotyczący - jak rozumiem - nałożenia pewnych ograniczeń wynika z bardzo wielu sytuacji będących czy zagrożeniami czy też naruszeniem dóbr, własności o czym wspomniałem na wykładzie przy okazji "kreatywności" w muzyce. Te sprawy na pewno muszą i będą lub już są (zależnie od kraju) regulowane prawne. W Polsce już w 2019 roku, w ramach rządowej grupy eksperckiej (w której osobiście uczestniczyłem), opracowującej strategię rozwoju AI w Polsce (w ramach szerszego projektu europejskiego) pojawił się panel dotyczący AI i zagadnień prawnych. Generatywna AI na pewno wymusza zmianę podejścia do oceny różnych prac dyplomowych (licencjackie, magisterskie, doktorskie, w pewnych sytuacjach monografie habilitacyjne - obecnie w habilitacji brana jest całość dorobku w ramach pewnej subdyscypliny/zagadnienia i nie musi to być praca w formie podobnej do pracy doktorskiej, choć zakłada się albo monografie albo zbiory publikacji w czasopismach naukowcy). Z pewnością znajdą się naukowcy lub kandydaci na formalny status naukowców, dla których AI będzie pokusą pójścia na skróty. Klasyczne współczesne systemy antyplagiatowe mogą być bezradne i potrzebne będą (już są potrzebne) inne rozwiązania uzupełniające te systemy. Jednym z takich rozwiązań mogą być konsekwencje prawne, dyscyplinarne itp. Z drugiej strony - o czym wspomniałem na wykładzie - będzie działała druga siła, tj. powoli będzie wysychało źródło bezpłatnych i nieautoryzowanych (bez przypisów, powołań/referencji) publikacji w Internecie, pobieranych bezpłatnie do procesu uczenia dużych systemów AI opartych na LLM i GPT, ale nie tylko, bo także systemów bardziej wyspecjalizowanych np.: "tworzących muzykę" czy obrazy, grafikę.

Dla przykładu OpenAI (o czym chyba wspomniałem na wykładzie) rozważa użycie etykietowania treści generowanych przez AI, czegoś w rodzaju znaków wodnych (ang. watermarks) - więcej np. w tym artykule OpenAI: https://openai.com/index/understanding-the-source-of-what-we-see-and-hear-online/ . Problem jest bardzo aktualny i ważny, więc zajęła się nim nie tylko OpenAI, dołączył również Microsoft i Google. To trochę jak ta druga siła tylko o przeciwnym zwrocie. Myślę, że w najbliższym czasie będzie coraz więcej informacji - wraz z rosnącą świadomością rangi tego problemu.

U5:

18:50 Widać gitary każda po sześć kluczy :)

Tak, te gitary w tle mają po 6 kluczy do strojenia, bo to są prawdziwe, moje gitary! :)